特别说明:本文由学研汇技术中心原创撰写,旨在分享相关科研知识。因学识有限,难免有所疏漏和错误,请读者批判性阅读,也恳请大方之家批评指正。

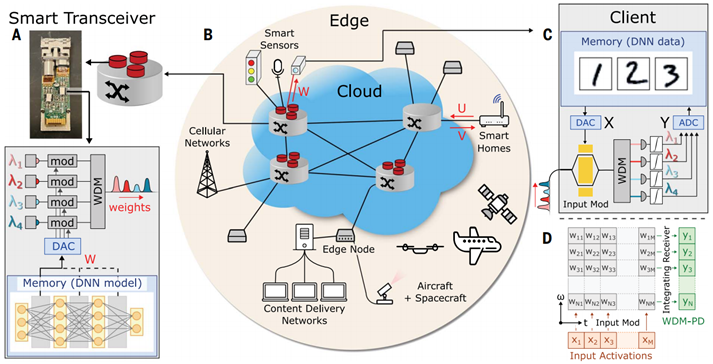

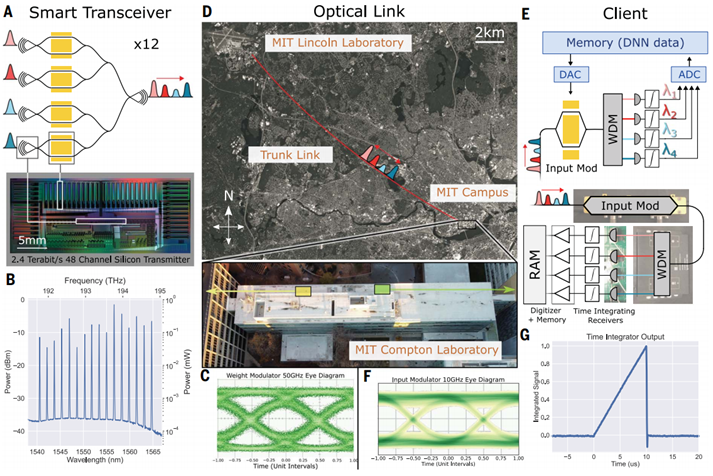

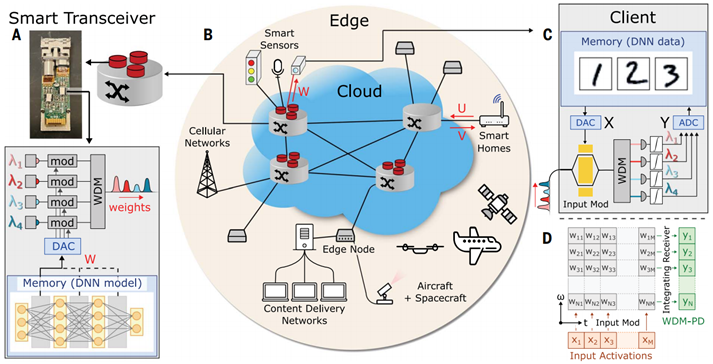

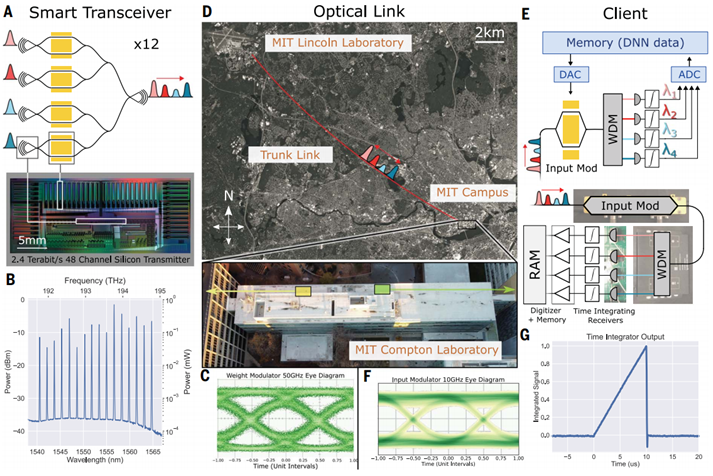

近年来,深度神经网络(DNN,机器学习领域中一种技术)的进展有效地推动了各类科学和技术的发展。但DNN不断增长的计算需求使得其在低功耗设备(如智能手机和传感器)上难以应用。尽管目前有许多研究正在尝试降低功耗,但由于矩阵代数、神经形态、模拟存储器和光子网格等模拟方法都存在较大功耗,因此仍然没有实现有效的降低。为了使先进的DNN在低功耗设备上应用可及,工业界已尝试将计算量大的DNN推理转移到云服务器上,例如,智能家庭设备可以将语音查询作为向量U发送到云服务器,再由云服务器将推断结果V返回给客户端,但这种方式存在较长的延迟(~200 ms),此外安全风险也较高,在私人数据上存在安全漏洞。最近,来自麻省理工学院电子研究实验室的Dirk Englund和Ryan Hamerly等人首次提出了一种基于跨网络非局域模拟处理的机器学习推理方法,通过引入一种名为Netcast的光子边缘计算架构,成功实现了大型线性代数运算(如通用矩阵向量乘法(GEMV))的最小化能耗和延迟。

1) 在Netcast架构中,云服务器以模拟格式将DNN权重数据(W)流式传输到边缘设备,以实现高效的光学GEMV,从而消除所有本地权重内存访问;2) 研究证实在超低光能下的图像识别下,可以达到每倍增40阿托焦(每倍增<1光子),且分类准确率为98.8%(93%),研究者还通过在波士顿地区的现场试验辅证了该性能;3) Netcast可以在使用具有最小内存和处理能力的毫瓦级边缘设备的情况下,为高功率(>100瓦)云计算机以teraFLOPS速率进行计算。

参考文献:

Dirk E., et al. Delocalized photonic deep learning on the internet’s edge. Science (2022).

DOI: 10.1126/science.abq8271

https://www.science.org/doi/10.1126/science.abq8271